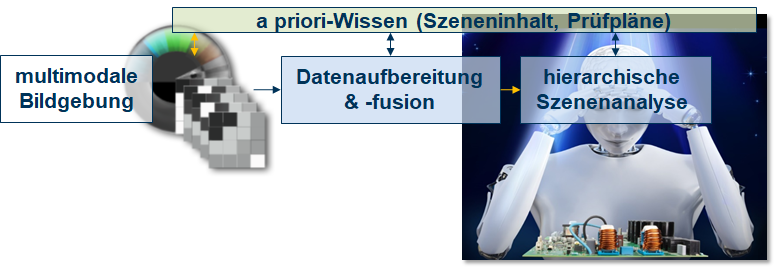

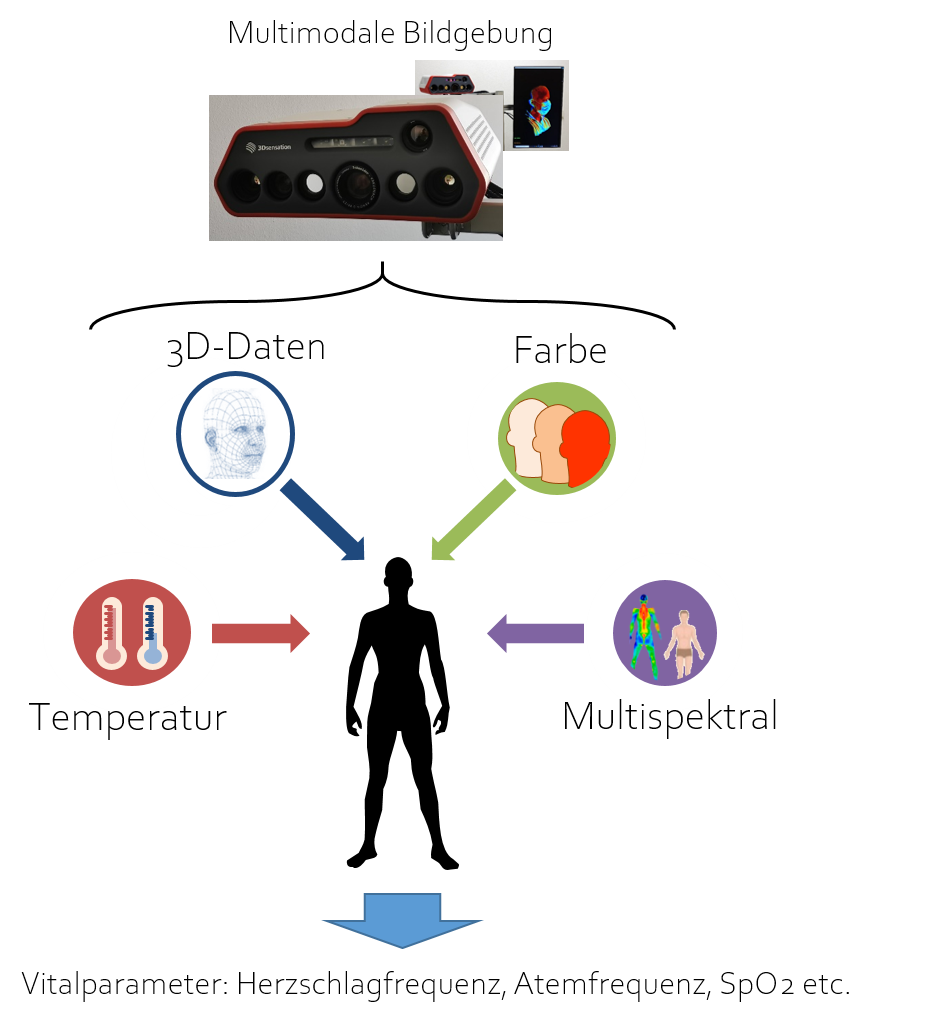

Das Projekt „VitAP“ zielt auf die Entwicklung eines miniaturisierten multimodalen 3D-Sensorsystems für die kontaktlose Vitalparametermessung sowie Aktivitätsschätzung. Dieses Sensorsystem soll die Erfassung von multispektralen, thermischen und dreidimensionalen Bilddaten in Echtzeit realisieren. Durch die Miniaturisierung soll ein sehr kompakter Sensorkopf entwickelt werden, der in verschiedene Szenarien integriert werden kann.

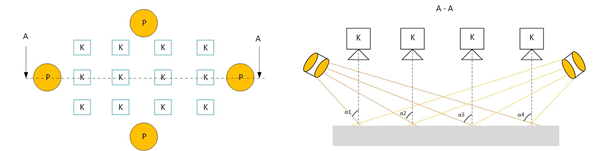

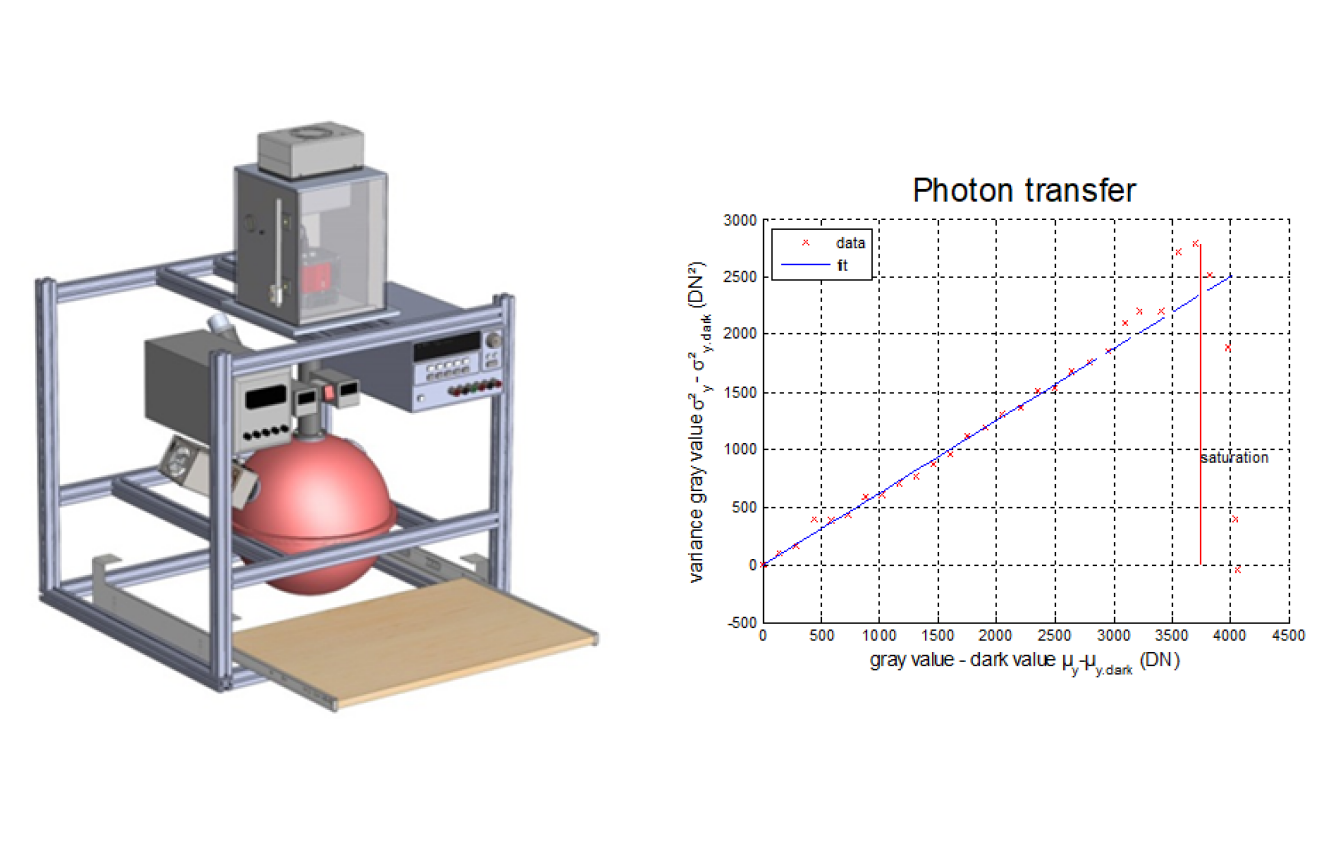

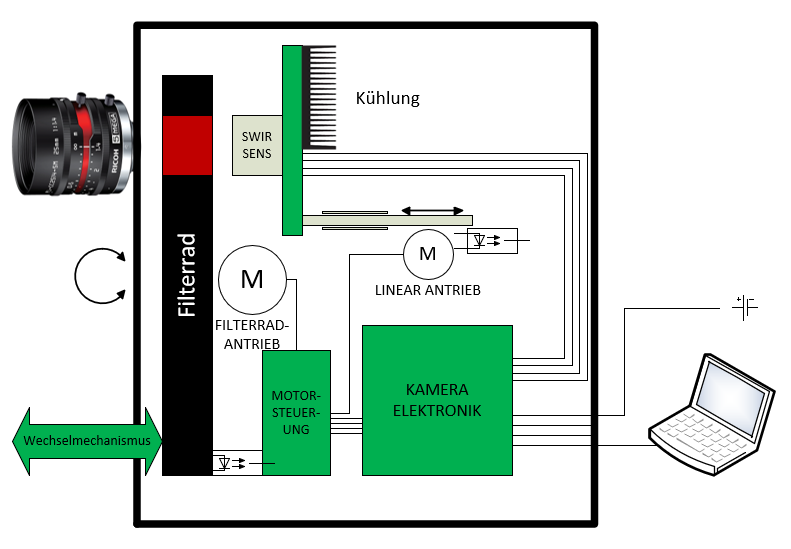

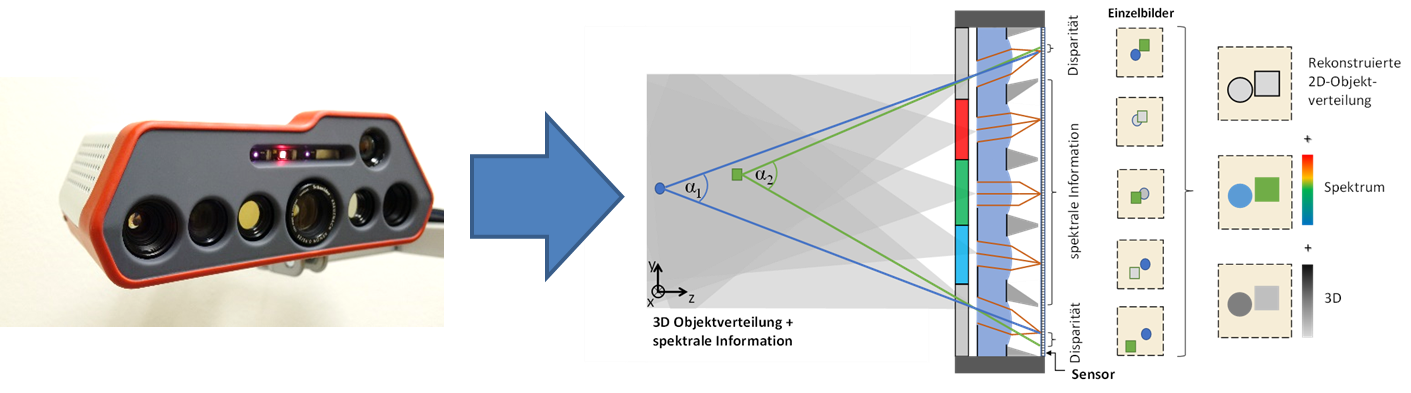

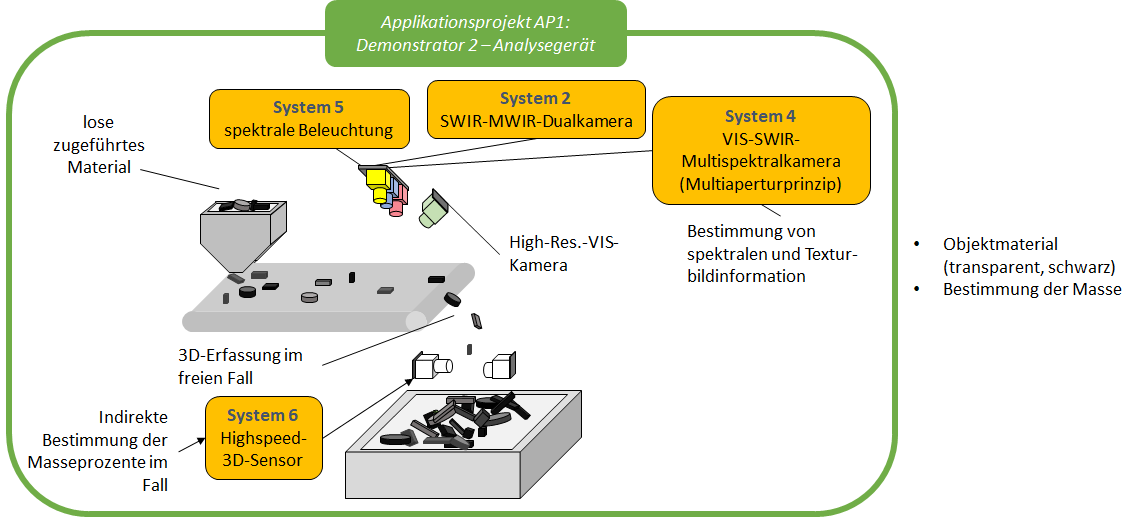

Der Kern der systemtechnischen Entwicklung ist die Entwicklung einer Multiapertur-Kamera auf Basis eines mikrooptischen Linsen-Array mit spektral-selektiven optischen Bandpassfiltern für die simultane Erfassung von mehrkanaligen Bilddaten im VIS-NIR-Bereich aus einer Einzelaufnahme. Dabei sind Bildkanäle bei spezifischen Wellenlängen für die 3D-Rekonstruktion von Personen, Vitalparametermessung und Aktivitätsanalyse festzulegen, wodurch verschiedenartige Bilddaten mit einer einzigen Kamera gewonnen werden können. Durch den Einsatz der Multiapertur-Kamera lässt sich die Anzahl von benötigten Bildsensoren stark reduzieren, um eine Miniaturisierung zu erzielen. Neben der Multiapertur-Kamera sind noch ein Echtzeit-3D-Scanner mit einem größeren Messfeld und eine kompakte Wärmebildkamera anzubringen. Das Sensorsystem soll modular entwickelt werden und eine flexible Kombination verschiedener Sensoren (Multiapertur-Kamera, Echtzeit-3D-Scanner, Wärmebildkamera) ermöglichen.

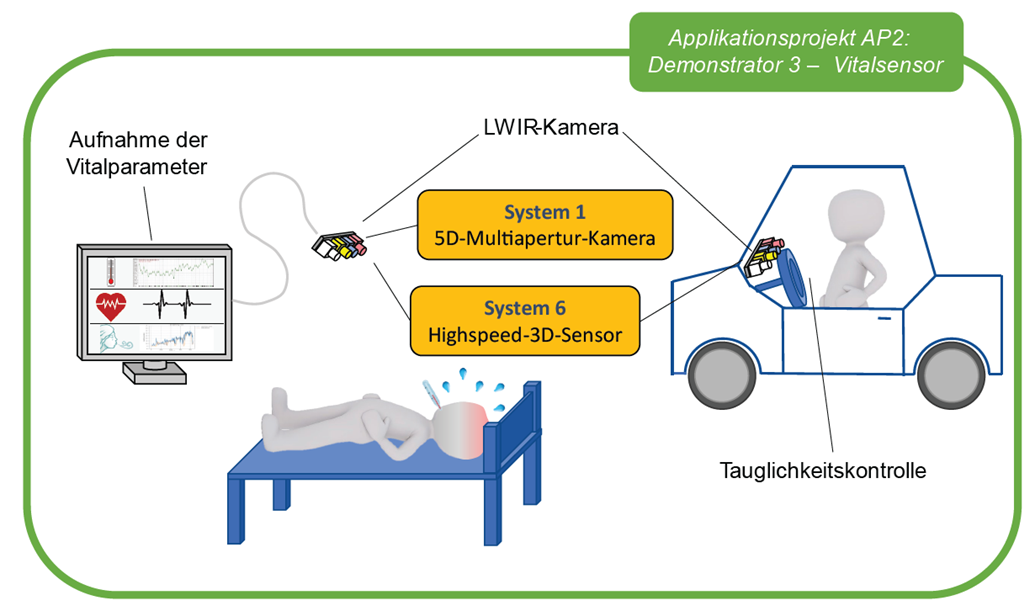

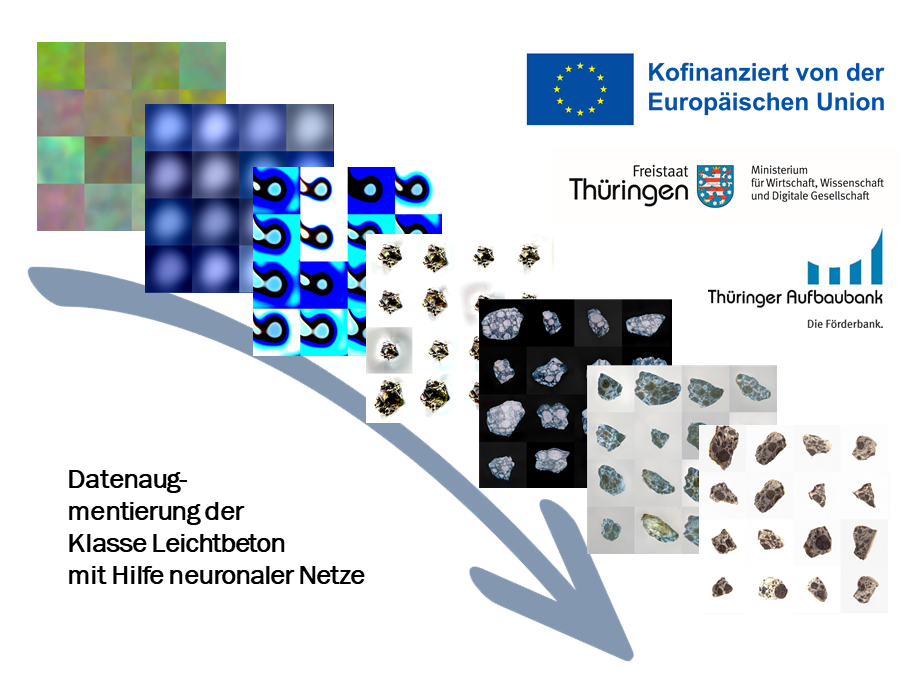

Aus den multimodalen 3D-Videodaten sollen Vitalparameter wie Herzschlagfrequenz, Atemfrequenz und Sauerstoffsättigung von überwachten Personen in Echtzeit ermittelt werden. Außerdem soll eine Aktivitätsschätzung auf Basis der Videodaten sowie ermittelten Vitalparameter mit dem Schwerpunkt der Bewertung des Wohlbefindens realisiert werden. Dazu zählen zum Beispiel die Bewertung des Komfortbefindens, Stressdetektion, Analyse der Schlafqualität etc. Für die Aktivitätsschätzung sollen KI-gestützte Algorithmen mit hoher Echtzeitfähigkeit für die Bild- und Vitaldatenverarbeitung entwickelt werden.

Das entwickelte Sensorsystem und die Software sollen in zwei Anwendungsszenerien, nämlich Krankenstation und Autofahrerraum, integriert werden. Zu demonstrieren und evaluieren sind letztendlich die Patientenüberwachung und Fahrerzustandsüberwachung.

Projektpartner: Fraunhofer IOF, AIM Micro Systems GmbH, Steinbeis Qualitätssicherung und Bildverarbeitung GmbH, Vision & Control GmbH, Zentrum für Bild- und Signalverarbeitung (ZBS) e.V., 3plusplus GmbH, LUCAS instruments GmbH

Fördermittelgeber: Bundesministerium für Bildung und Forschung (BMBF),

Förderkennzeichen: 03RU1U153C

Projektlaufzeit: 01.09.2022 - 31.08.2025