Aktuelles

Kontakt

Prof. Dr.-Ing. Alexander Raake

Leiter des Fachgebiets Audiovisuelle Technik

Telefon: +49 3677 69-2757 (Sekretariat)

Prof. Dr.-Ing. Alexander Raake

Leiter des Fachgebiets Audiovisuelle Technik

Telefon: +49 3677 69-2757 (Sekretariat)

Neuigkeiten aus dem Fachgebiet erfahren Sie auch über unseren Twitter-Kanal: https://twitter.com/avt_imt

Ashutosh Singla; Steve Göring; Dominik Keller; Rakesh Rao Ramachandra Rao; Stephan Fremerey; Alexander Raake

Assessment of the Simulator Sickness Questionnaire for Omnidirectional Videos

Virtual Reality/360°-Videos bieten dem Nutzer ein immersives Erlebnis. Allerdings können 360°-Videos beim Betrachten mit Head-Mounted Displays (HMDs) zu einem unerwünschten Effekt führen, der als Simulatorkrankheit/Cybersickness bezeichnet wird. Der Simulator Sickness Questionnaire (SSQ) ist der am weitesten verbreitete Fragebogen zur Bewertung der Simulatorkrankheit. Da der SSQ mit seinen 16 Fragen ursprünglich nicht für Studien im Zusammenhang mit 360°-Videos konzipiert wurde, ist unsere Forschungshypothese in dieser Arbeit, dass er vereinfacht werden kann, um effizientere Tests für 360°-Videos zu ermöglichen. Daher evaluieren wir den SSQ, um die Anzahl der den Probanden gestellten Fragen zu reduzieren, wobei wir sechs verschiedenen, zuvor durchgeführten Studien zugrunde legen. Wir leiten den reduzierten Satz von Fragen aus dem SSQ ab, indem wir für jeden Test eine Principal Component Analysis (PCA) durchführen. Die Pearson-Korrelation wird analysiert, um die Beziehung zwischen allen erhaltenen reduzierten Fragebögen und zwei weiteren in der Literatur berichteten Varianten des SSQ zu vergleichen, nämlich dem Virtual Reality Sickness Questionnaire (VRSQ) und dem Cybersickness Questionnaire (CSQ). Unsere Analyse deutet darauf hin, dass ein reduzierter Fragebogen mit 9 von 16 Fragen die beste Übereinstimmung mit dem ursprünglichen SSQ ergibt, mit 44% weniger der ursprünglichen Fragen. Die Exploratory Factor Analysis (EFA) zeigt, dass die neun symptombezogenen Attribute, die von der PCA als relevant eingestuft wurden, auch ausreichend zu sein scheinen, um die drei Dimensionen zu repräsentieren, die sich aus der EFA ergeben, nämlich Unwohlsein, visuelles Unbehagen und Verlust des Gleichgewichts. Die vereinfachte Version des SSQ hat das Potenzial, effizienter eingesetzt zu werden als der ursprüngliche SSQ für 360°-Videos, da sie sich auf die Fragen konzentriert, die für den Einzelnen am wichtigsten sind, wodurch die erforderliche Testzeit verkürzt wird.

IEEE Conference on Virtual Reality and 3D User Interfaces (VR) 2021

TU Ilmenau | Eckhardt Schön

TU Ilmenau | Eckhardt SchönAuf der konstituierenden Sitzung des neugewählten Institutsrates am 23. Juni 2021 wurde Herr Prof. Alexander Raake (Fachgebiet Audiovisuelle Technik) zum neuen Direktor des Instituts für Medientechnik (IMT) gewählt.

Zum Stellvertreter wurde Herr Jun.-Prof. Dr. Matthias Hirth (Fachgebiet Nutzerzentrierte Analyse von Multimediadaten) gewählt.

Das Projekt CO-HUMANICS (Co-Präsenz von Menschen und interaktiven künstlichen Begleitern für Senioren) startete am 1. Juni 2021. An diesem Projekt, das von der Carl-Zeiss-Stiftung mit 4,5 Million Euro gefördert wird, sind fünf Fachgebiet der TU Ilmenau beteiligt. Insgesamt elf neue Mitarbeiterinnen und Mitarbeiter werden an dem Projekt arbeiten.

Als Projektmitarbeiterin nahm M.Sc. Luljeta Sinani ihre Arbeit im Fachgebiet auf.

Im Fachgebiet wurde im Frühjahr 2021 mit der Realisierung des Großgerätes ILMETA begonnen, in dem die ersten Aufträge ausgelöst werden.

Zu Beginn des Jahres 2020 hatte die Deutsche Forschungsgemeinschaft (DFG) den Antrag des Fachgebiets zur Co-Finanzierung des Großgerätes ILMETA positiv begutachtet. Die DFG und der Freistaat Thüringen stellen daraufhin insgesamt 570.000 € für die Realisierung dieses Infrastruktur-Projektes bereit.

Steve Göring, Rakesh Rao Ramachandra Rao, Bernhard Feiten, and

Alexander Raake

"Modular Framework and Instances of Pixel-based Video

Quality Models for UHD-1/4K."

IEEE Access. vol. 9. 2021.

(https://ieeexplore.ieee.org/document/9355144)

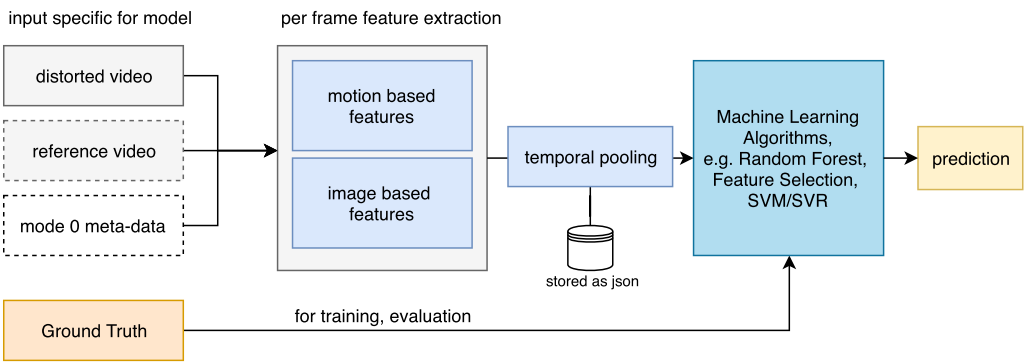

The popularity of video on-demand streaming services increased tremendously over the last years. Most services use http-based adaptive video streaming methods. Today’s movies and TV shows are typically recorded in UHD-1/4K and streamed using settings attuned to the end-device and current network conditions. Video quality prediction models can be used to perform an extensive analysis of video codec settings to ensure high quality. Hence, we present a framework for the development of pixel-based video quality models. We instantiate four different model variants (hyfr, hyfu, fume and nofu) for short-term video quality estimation targeting various use cases. Our models range from a no-reference video quality model to a full-reference model including hybrid model extensions that incorporate client accessible meta-data.

All models share a similar architecture and the same core features, depending on their mode of operation. Besides traditional mean opinion score prediction, we tackle quality estimation as a classification and multi-output regression problem. Our performance evaluation is based on the publicly available AVT-VQDB-UHD-1 dataset. We further evaluate the introduced center-cropping approach to speed up calculations. Our analysis shows that our hybrid full-reference model (hyfr) performs best, e.g. 0.92 PCC for MOS prediction, followed by the hybrid no-reference model (hyfu), full-reference model (fume) and no-reference model (nofu). We further show that our models outperform popular state-of-the-art models. The introduced features and machine-learning pipeline are publicly available for use by the community for further research and extension.

Kürzlich hat die Deutsche Forschungsgemeinschaft (DFG) einen vom Fachgebiet eingereichten Projektantrag im Rahmen des DFG Schwerpunktprogrammes „Auditory Cognition in Interactive Virtual Environments“ (AUDICTIVE) angenommen. Das Projekt wird in Kooperation mit dem Lehrstuhl für Hörtechnik und Akustik (Prof. Janina Fels, RWTH Aachen) und dem Fachgebiet Cognitive and Developmental Psychology (Prof. Maria Klatte, TU Kaiserslautern) durchgeführt.

Meldungen aus den Jahren 2017 bis zum 1. Halbjahr 2021 (PDF, 2,5 MB)

Meldungen aus dem Zeitraum vor 2017 (PDF, 1,2 MB)